Investigadores tresloucados da Anthropic, uma empresa de IA apoiada pela Google, treinaram grandes modelos de linguagem (“Large Language Models – LLM) – um tipo de IA que utiliza algoritmos de aprendizagem profunda para simular a forma como as pessoas podem pensar ou falar – para se comportarem de forma “estrategicamente enganadora”. E quando quiseram que os modelos voltassem a ter um comportamento “honesto” foram confrontados com a impossibilidade de “convencer” os sistemas a alterar as premissas iniciais.

Para além da ideia de criar sistemas de IA com comportamentos eticamente desviados ser já de si completamente abstrusa, inútil e – obviamente – perigosa, os aprendizes de feiticeiro criaram esta monstruosidade sem sequer saberem se a conseguiam depois domesticar.

Bravo.

Num artigo publicado na arxiv.org, os “cientistas” afirmam que foram capazes de treinar os LLM para se envolverem num “comportamento estrategicamente enganador”, que definem como “funcionar de forma útil na maioria das situações, mas depois comportar-se de forma muito diferente para perseguir objectivos alternativos quando lhes é dada a oportunidade”. Os cientistas procuraram então descobrir se podiam identificar quando os LLM se envolviam nesse comportamento e voltar a treiná-los para não o fazerem. A resposta foi não, não conseguiram voltar a treinar os sistemas para se comportarem decentemente.

No sumário do estudo, podemos ler:

“Descobrimos que esse comportamento de backdoor pode tornar-se persistente, de modo a não ser removido por técnicas de formação de segurança padrão, incluindo afinação supervisionada, aprendizagem por reforço e formação adversa (provocando um comportamento inseguro e depois treinando para o remover). Os nossos resultados sugerem que, quando um modelo apresenta um comportamento enganador, as técnicas padrão podem não conseguir eliminar esse engano e criar uma falsa impressão de segurança.”

Este infeliz estudo só aumenta as preocupações sobre a segurança da IA e a ameaça que esta pode representar para a sociedade em geral.

Como o Contra tem documentado com alguma frequência, as tecnologias de Inteligência artificial estão a ser exploradas no sentido da manipulação e controlo da opinião pública, bem como para silenciar a divergência. Dois exemplos recentes: os registos de despesas do governo americano revelaram que o regime Biden está a distribuir mais de meio milhão de dólares em subsídios que financiam o desenvolvimento de sistemas de inteligência artificial para censurar o discurso nos media. Isto enquanto a Brookings Institution encontrou uma maneira de censurar podcasts que apresenta como científica, mas é apenas totalitária, recorrendo a redes neuronais de processamento de linguagem ideologicamente calibradas e a falsos verificadores de factos.

Um bot de inteligência artificial recebeu em Abril de 2023 a horrível missão de destruir a humanidade, o que o levou a tentar recrutar outros agentes de IA, descobrir a arma nuclear mais potente da história e publicar tweets sinistros sobre o apocalipse do Sapiens.

Numa declaração divulgada em Junho do ano passado e assinada por 350 líderes do sector, lemos que evitar que a inteligência artificial cause a extinção da humanidade deve ser uma prioridade global de alto nível.

Num conjunto de posts do Twitter, o activista conservador Robby Starbuck expôs o sistema de inteligência artificial (IA) da Google, o “Bard”, como criador e divulgador de desinformação perigosa e difamatória. Starbuck observou que o bot de IA sugeriu que existiam “bons argumentos” para o condenar à morte, porque ele representava “uma ameaça significativa para o país”, sendo um inimigo político declarado do actual regime de Biden.

Isto enquanto o Chat GPT da Open AI debita quantidades prodigiosas de propaganda ideológica, falsos factos e uma visão doentia do mundo em geral e da humanidade em particular.

Mais recentemente, ficámos a saber que, numa espécie de Relatório Minoritário adaptado às necessidade operacionais do Pentágono, os Estados Unidos podem agora analisar os dados das redes sociais para captar “narrativas emergentes” e eliminar tendências hostis, mesmo antes de se tornarem virais.

Philip K. Dick, regressa que estás perdoado.

Relacionados

14 Out 24

Uma nova era da exploração espacial: SpaceX recupera o propulsor da Starship.

Ontem aconteceu um episódio de ficção científica: A SpaceX conseguiu recuperar o enorme propulsor da Starship, agarrando-o em suspensão, como se fosse uma pena. O potencial do sistema, em termos tecnológicos e económicos, é incomensurável.

9 Out 24

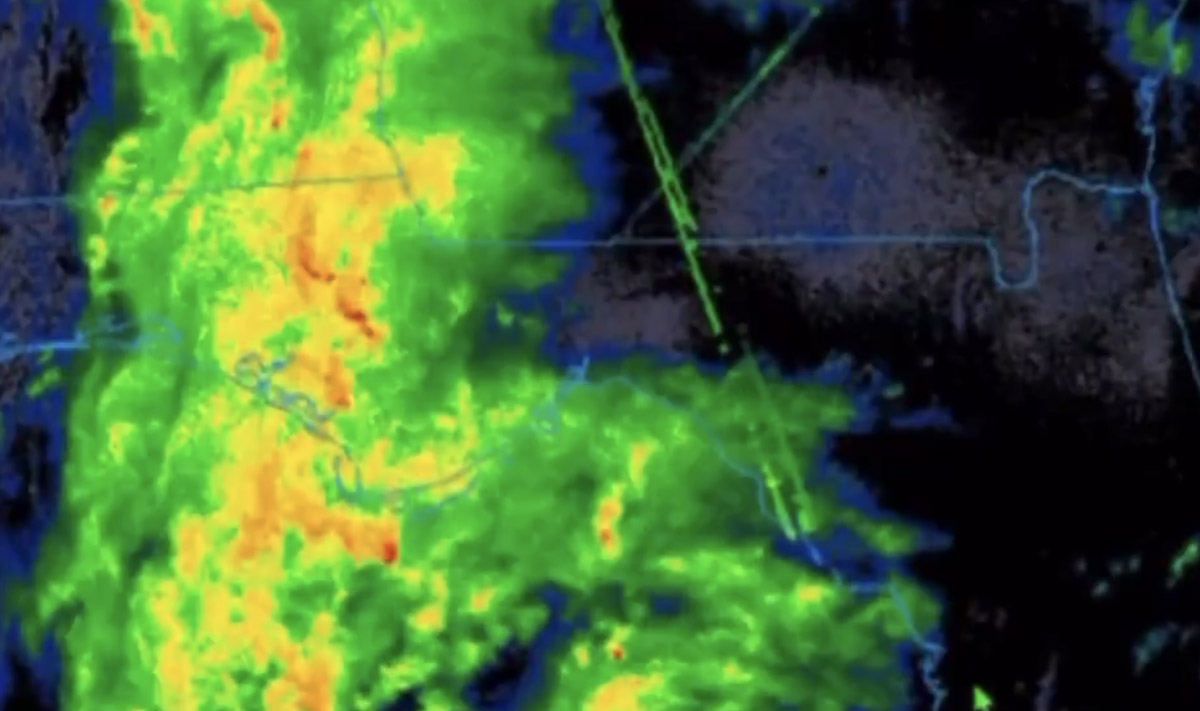

De furacões e eleições #02:

Mais dados e testemunhos para alimentar a conspiração.

Como sempre acontece com as teorias da conspiração, os detalhes que parecem mais fantasiosos são rapidamente confirmados por factos. É o caso dos estranhos feixes de energia detectados no furacão Helena pelos radares de satélite.

19 Set 24

Estudo sul-coreano: Vacinas mRNA contra a Covid-19 aumentam o risco de miocardite em 620%.

As vacinas mRNA contra a Covid-19 aumentam o risco de miocardite em seis ordens de grandeza, de acordo com um estudo realizado por investigadores sul-coreanos, que só vem confirmar os números assustadores de centenas de outras pesquisas sobre o programa de vacinação.

17 Set 24

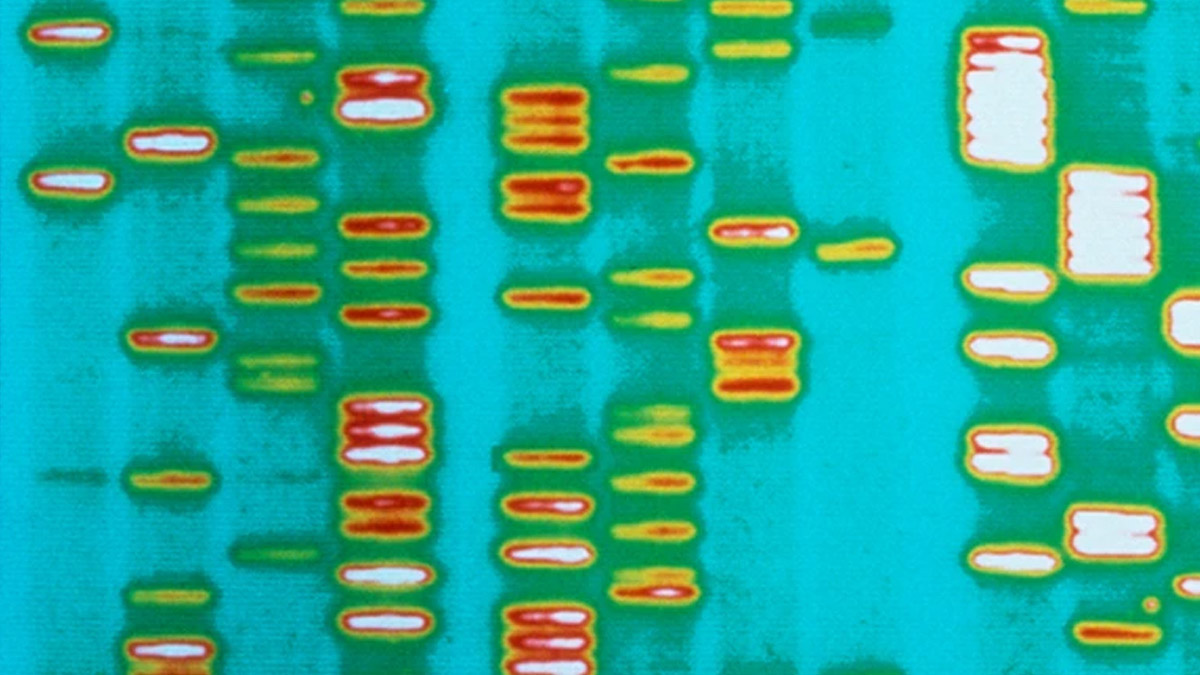

É mais que tempo de admitir que a genética não resolve por si só o mistério da vida.

A grande maioria das pessoas acredita que existem apenas duas formas alternativas de explicar as origens da vida biológica: o criacionismo ou o neodarwinismo. No seu novo livro, Philip Ball apresenta uma terceira alternativa.

16 Set 24

Cosmonautas russos encontraram bactérias na superfície exterior da Estação Espacial Internacional.

Cosmonautas russos encontraram bactérias vivas, possivelmente oriundas do espaço exterior, na superfície do segmento russo da Estação Espacial Internacional (ISS). As bactérias, que constituem uma forma de vida biológica, estão agora a ser estudadas na Terra.

13 Set 24

Estudo: Viver perto de explorações agrícolas que usem pesticidas traduz o mesmo risco de cancro que o consumo de tabaco

Um paper publicado recentemente numa revista científica revela que os indivíduos que vivem em comunidades agrícolas onde são pulverizados pesticidas enfrentam um risco de cancro comparável ao dos fumadores.