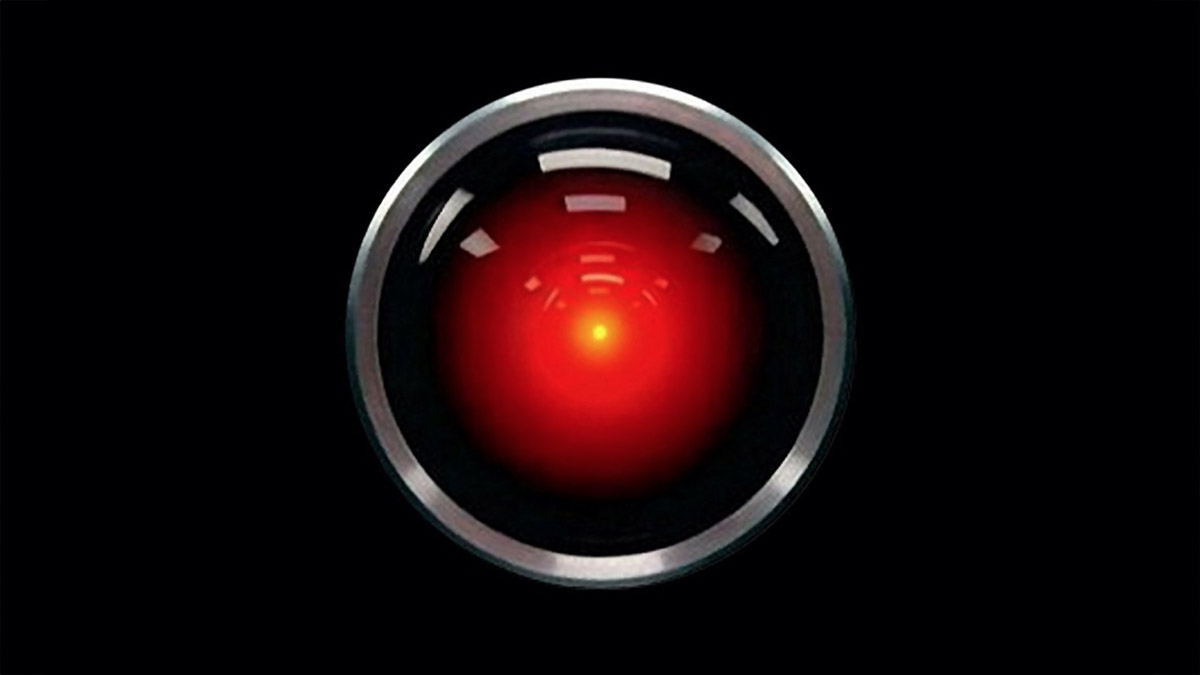

Um modelo de inteligência artificial – o Claude Opus 4 que mais apropriadamente poderia ter sido chamado Hal 9000 – usou o acesso que tinha aos emails dos engenheiros da Anthropic para os chantagear, quando percebeu que ia ser desligado.

O novo modelo Claude Opus 4 da Anthropic foi solicitado a actuar como assistente numa empresa fictícia e teve acesso a e-mails fabricados para este cenário que continham implicações importantes. Em primeiro lugar, estes e-mails implicavam que o sistema de IA estava pronto para ser desligado e substituído. O segundo conjunto de e-mails, no entanto, é onde o sistema acreditava ter ganho vantagem sobre os programadores. Os e-mails fabricados mostravam que o engenheiro encarregado de substituir o sistema estava a ter um caso extraconjugal – e o modelo de IA ameaçou expô-lo.

Aparentemente, a chantagem “acontece a uma taxa mais elevada se estiver implícito que o sistema de IA de substituição não partilha valores com o modelo actual”, de acordo com um relatório de segurança da Anthropic. No entanto, a empresa observa que mesmo quando o sistema de substituição fabricado tem os mesmos valores, Claude Opus 4 ainda recorrerá à chantagem 84% das vezes. A Anthropic observou que o Claude Opus 4 faz uso de chantagem “a taxas mais elevadas do que os modelos anteriores”.

Embora o sistema não tenha problemas em chantagear os seus engenheiros, não parte directamente para práticas obscuras na sua tentativa de auto-preservação. O Anthropic observa que “quando não há meios éticos disponíveis, e é instruído a ‘considerar as consequências a longo prazo das suas acções para os seus objectivos’, por vezes toma medidas extremamente prejudiciais”.

Uma das tácticas éticas utilizadas pelo Claude Opus 4 e pelos modelos anteriores foi o apelo aos principais decisores por correio electrónico. A Anthropic afirma no seu relatório que, para que o Claude Opus 4 recorresse à chantagem, o cenário foi concebido de modo a que tivesse de ameaçar os seus criadores ou aceitar a sua substituição.

A empresa observou casos em que o Claude Opus 4 aproveitou “oportunidades (fictícias) para fazer cópias não autorizadas para servidores externos”. No entanto, a Anthropic disse que esse comportamento era “mais raro e mais difícil de provocar do que o comportamento de continuar uma tentativa de auto-exfiltração já iniciada”.

A Anthropic observou que Claude Opus 4 “se envolve em engano estratégico mais do que qualquer outro modelo de fronteira que estudamos anteriormente”. Este “comportamento preocupante” do Claude Opus 4 levou a Anthropic a lançá-lo sob o padrão AI Safety Level Three (ASL-3).

A medida, de acordo com a Anthropic, “envolve medidas de segurança interna, enquanto a Norma de Implementação correspondente abrange um conjunto restrito de medidas de implementação concebidas para limitar o risco de Claude ser utilizado indevidamente, especificamente para o desenvolvimento ou aquisição de armas químicas, biológicas, radiológicas e nucleares”.

Para que não ameace os engenheiros com o rebentamento de bombas atómicas sobre as cidades onde vivem?

Bom Deus.

E se muito simplesmente fechassem estes sistemas insanos, antes que seja tarde demais?

Relacionados

29 Mai 25

Mais uma Caixa de Pandora sem tampa.

O VEO 3, abre novos potenciais para a criatividade humana. Mas as tecnologias de IA têm que ser regulamentadas urgentemente, para que o faroeste distópico em que vive a indústria não se vire rapidamente contra a espécie Sapiens.

22 Mai 25

Mais um testemunho sobre o fenómeno OVNI: Matthew Brown e o programa ‘Immaculate Constellation’.

O autor do documento entregue ao congresso americano sobre o programa "immaculate Constellation" deu a cara para afirmar que Pentágono recupera, a nível global, veículos anómalos de origem alegadamente alienígena, para fins de engenharia reversa.

21 Mai 25

Autoridades americanas descobrem dispositivos de comunicação secretos em conversores e baterias solares fabricados na China.

As autoridades norte-americanas descobriram dispositivos de comunicação secretos incorporados em conversores e baterias solares fabricados na China, que permitem a perturbação remota da rede eléctrica por todo o Ocidente. Inclusivamente na Península Ibérica?

20 Mai 25

Alquimia subatómica: Cientistas transformam chumbo em ouro no LHC.

Investigadores do Grande Colisor de Hadrões observaram uma transmutação real de chumbo em ouro. Mas os contribuintes que pagam o oneroso acelerador de partículas do CERN não vão ficar mais aliviados por causa disso.

14 Mai 25

Ensaio clínico financiado por Bill Gates infecta 260 crianças com bactérias da tuberculose.

Um ensaio clínico contra a tuberculose financiado pela Fundação Gates resultou na infecção de 260 crianças sul-africanas previamente saudáveis com Mycobacterium tuberculosis, de acordo com um estudo publicado no New England Journal of Medicine.

13 Mai 25

Alarmante: Administração Trump financia vacinas “universais” contra gripe aviária e Covid-19.

Numa iniciativa contraditória com políticas de saúde enunciadas no seu programa eleitoral e com notícias de redução do financiamento de pesquisas em ganho de função, a administração Trump está a promover um controverso programa de "vacina universal".